Lutter contre l’oubli : sciences cognitives et machine learning

L’ancrage mémoriel - qu’on appelle aussi révisions dans le milieu scolaire - rappelle des expressions plutôt négatives telles que le bachotage, le par cœur ou encore les récitations. Et si les sciences cognitives et le machine learning pouvaient rendre cette étape plus efficiente et efficace ?

Lors de mon stage de fin d'étude chez Domoscio, j'ai eu la chance de travailler dans un domaine particulier : « l'educational data mining », c’est-à-dire la fouille de données éducatives. L'objectif de ce stage était l'amélioration d'un système d'ancrage (autrement dit un système d'aide à la révision) pour le rendre adaptatif, c'est-à-dire capable de prendre en compte le contexte, par exemple le thème et l'utilisateur.

On oublie environ 80% de ce que l'on a appris en un mois !

Hermann Ebbinghaus, philosophe allemand, est le premier à s'intéresser de façon rigoureuse à la mémoire et à notre façon de mémoriser. Il mène sur lui-même plusieurs expériences afin d'établir une série de mesure sur l'oubli. Il va montrer notamment que l'on oublie environ 80% de ce que l'on a appris en un mois. Si ce chiffre varie évidemment avec le thème et la personne concernés, c'est souvent celui qui est retenu pour sa valeur historique.

Cette problématique de l’oubli est centrale dans la formation : si une connaissance est oubliée, elle ne peut pas être mise en application, ni être sollicitée pour intégrer une nouvelle connaissance plus complexe. Tant que l’on ne parlait pas de formation tout au long de la vie, cette problématique était relativement cantonnée à la formation initiale et aux jeunes apprenants sur les bancs de l’école. Avec le développement de la formation continue dû à l’évolution rapide des métiers et des compétences nécessaires, cette problématique va maintenant nous suivre tout au long de notre vie.

De nombreux successeurs d'Ebbinghaus ont travaillé pour continuer à comprendre la mémoire, et surtout pour lutter contre l'oubli. Plusieurs travaux ont pu mettre en valeur les pistes suivantes :

Les révisions espacées : des chercheurs ont pu montrer que faire des révisions de façon espacée avait un impact beaucoup plus fort sur la rétention, ainsi il vaut mieux passer six fois 10 minutes sur un sujet, plutôt que de passer une heure en une seule fois dessus. C’est ce qu’on appelle le « spacing effect ».

Les révisions sous format de question : faire des tests est la façon la plus efficace de faire des révisions. De façon assez incroyable, même faire des tests sans savoir si la réponse que l’on a fournie est bonne ou pas (sans feedback) reste plus efficace que simplement relire les documents de la formation !

Implication : ce point-là est déjà connu ; lors de l’apprentissage de la connaissance, une plus grande concentration et une plus grande implication facilitera la rétention mémorielle. Par exemple, comprendre les raisons qui aboutissent à un phénomène physique, ou bien trouver des exemples d’une particularité linguistique.

Mise en application : lorsqu’une connaissance est mise en application, c’est-à-dire quand elle est utilisée, elle va évidemment être plus facile à retenir, par l’expérience.

Ces éléments nous permettent de savoir comment mieux réviser, notamment en répartissant les révisions. Mais comment choisir les dates optimales de révision ? C’est ici que la partie ingénierie et data mining commence, avec la modélisation de l’oubli et la détection de dates critiques.

Plusieurs modélisations de la décroissance de la mémorisation ont été proposées.

Historiquement, c’est la fonction exponentielle ![]() qui est utilisée pour modéliser la décroissance de la mémoire : elle représente le pourcentage de chance de se souvenir du concept.

qui est utilisée pour modéliser la décroissance de la mémoire : elle représente le pourcentage de chance de se souvenir du concept.

D’autres personnes ont plutôt proposé une fonction puissance qui permet de respecter le principe de Jost suivant : « Etant donné deux souvenirs de la même force à un instant donné, mais n’ayant pas la même ancienneté, le plus ancien s’efface moins rapidement en un laps de temps donné ».

![]()

Où p est la probabilité de se souvenir du concept, A correspond à la mémoire immédiatement après le test, R est le taux d’oubli, et b est un paramètre d’échelle. Ces paramètres peuvent eux-mêmes être modélisés pour tenir compte de l’intervalle de temps entre deux révisions.

Une dernière modélisation intéressante est celle proposée par la célèbre application d’apprentissage des langues Duolingo :

![]()

Avec p la probabilité de se souvenir du concept, Δ le laps de temps écoulé depuis la dernière révision, et h le temps de demi-vie du souvenir. Duolingo fait l’hypothèse que le temps de demi-vie augmente de façon exponentielle grâce au spacing effect, et s’exprime donc :

![]()

Avec ![]() l’estimation de la demi-vie, x le vecteur de variables d’exposition au concept, et θ le vecteur des paramètres.

l’estimation de la demi-vie, x le vecteur de variables d’exposition au concept, et θ le vecteur des paramètres.

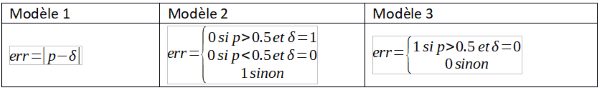

Il s’agit ensuite de confronter ces différents modèles à des données historiques, afin de choisir celui qui est le plus adapté. C’est ici que l’on fait appel aux outils de machine learning. D’abord on choisit comment modéliser l’erreur. Le Tableau 1 résume plusieurs propositions de modèles d’erreur en s’appuyant sur la probabilité de connaître un concept et sur la réponse de l’apprenant à une question qui porte sur ce concept, qui vaut 1 pour une bonne réponse, et 0 sinon.

Le premier modèle cherche simplement une pertinence « lisse » de la probabilité. Le deuxième modèle interprète la probabilité de façon dichotomique. Le troisième modèle ressemble au deuxième, mais cherche plutôt à pénaliser uniquement les moments où le modèle mémoriel n’a pas su prédire une mauvaise réponse de l’apprenant.

Tableau 1 – modélisations de l’erreur

Tableau 1 – modélisations de l’erreur

On choisit ensuite un algorithme de minimisation de cette estimation de l’erreur. Toutes les modélisations de la mémoire n’entraînent pas nécessairement une solution unique. Par ailleurs, les algorithmes d’optimisation peuvent parfois aboutir à trouver un maximum local différent du maximum global. Ce sont donc des vérifications à faire sur les modèles, et s’il y a un risque, l’algorithme d’optimisation doit être choisi en conséquence.

On évalue ensuite les modèles et leurs paramètres selon plusieurs critères : la minimisation de l’erreur choisie, éventuellement le temps de calcul des paramètres, ainsi que l’indicateur – que je ne définirai pas ici - très connu en science des données « AUC », ou aire sous la courbe ROC.

Enfin, la dernière étape consiste à calculer les meilleures dates de révisions en fonction de la modélisation choisie. Ce terme « meilleur » implique une subjectivité : que considère-t-on meilleur en termes d’apprentissage ? On compte par exemple la minimisation des révisions, la maximisation de la probabilité dans le temps, ou encore si on a un objectif daté (un examen, le lancement d’un produit…) le fait de s’en souvenir à cette date-là.

En appliquant toutes ces étapes d’un processus d’ingénierie de data science (compréhension du domaine d’application, modélisation, recherche des paramètres du modèle, et finalement utilisation du modèle), on peut donc parvenir à un outil capable d’aider l’apprentissage humain en luttant contre l’oubli grâce à la proposition de questions de révisions à des dates optimales.

Le domaine de l’educational data mining ne s’arrête cependant pas à cet outil : par exemple, on y trouve également la prédiction de décrochage, l’apprentissage adaptatif (c’est-à-dire trouver le meilleur contenu pédagogique pour l’apprenant), ou encore la prédiction des choix de spécialisation pour adapter les capacités d’accueil des filières.

Auteur

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.